La revolución silenciosa: inteligencia artificial, justicia social y cambio comunitario

Sara Duque Ruíz

Escritora, investigadora y editora del artículo. Trabajadora Social de la Universidad de Antioquia. [email protected]. ORCID: https://orcid.org/0009-0003-4182-3986

“Las tecnologías no son inocentes: llevan las huellas dactilares de quienes detentan el poder”.

—Ruha Benjamin (2019).

Introducción

La pregunta no es si la IA transformará nuestras comunidades, sino en beneficio de quién. Por lo tanto, hablaremos de este fenómeno como una revolución silenciosa, pues el despliegue de sistemas algorítmicos no es notorio en un inicio: avanzan a través de protocolos, bases de datos y decisiones automatizadas que se infiltran en la vida cotidiana. Su “silencio” radica en que sus efectos se perciben como resultados “neutrales”, cuando en realidad reproducen o disputan relaciones históricas de poder.

Para desglosar estos conceptos, inicialmente delimitamos el marco teórico que articula justicia social, decolonialidad y ética algorítmica. Luego, se describe el caso de la auditoría ciudadana al Sisbén IV y se detallan las tensiones entre sesgo algorítmico y organización popular. Para dar paso a la discusión, se proponen cinco principios para una IA comunitaria y decolonial, para integrar hallazgos empíricos y debates teóricos. Finalmente, a modo de conclusión, se discuten las implicaciones de una IA en la que participen las comunidades y se cuestione la ética detrás de los procesos.

Metodológicamente, el análisis se aproxima a un enfoque hermenéutico (al interpretar cómo los discursos sobre la IA configuran sentidos de justicia y poder en América Latina) y crítico (al contrastar esos discursos con prácticas concretas mediante la auditoría al algoritmo del Sisbén IV entre 2021 y 2024). Se emplearon técnicas de análisis documental y análisis comparativo de datos públicos para identificar sesgos y evaluar respuestas institucionales. Esta triangulación permite evidenciar persistencias coloniales en los circuitos de datos y, a la vez, la posibilidad de reorientar la tecnología hacia el bien común mediante gobernanza participativa.

¿Por qué la IA no es neutral? Hacia una ética desde el Sur

La seducción de la IA reside en su promesa de neutralidad. Sin embargo, las máquinas aprenden de datos anclados a estructuras de opresión (Benjamin, 2019; Noble, 2018). Por ejemplo, Buolamwini y Gebru (2018) ilustraron cómo los sistemas de reconocimiento facial fallan con mayor frecuencia en rostros racializados, fenómeno que Ruha Benjamin bautizó como New Jim Code. En América Latina, donde la brecha social es histórica, este código adquiere matices de colonialidad: los algoritmos no solo discriminan, sino que exportan criterios forjados lejos de los contextos que pretenden gobernar. La IA, por tanto, se convierte en el nuevo galeón de la extracción de valor cognitivo (Ricaurte, 2019).

Aceptar este diagnóstico implica repensar la ética. Los marcos globales, como los principios de la OCDE o las directrices de la Unesco, ofrecen referencias valiosas, pero a menudo parten de cosmologías eurocéntricas (Mignolo, 2011), es decir, visiones del mundo gestadas en la historia y la experiencia europea, que se presentan a sí mismas como universales. Desde el Sur Global se invoca otro prisma: la ética decolonial, que exige justicia cognitiva. Este concepto, acuñado por Boaventura de Sousa Santos (2014), parte de la convicción de que todos los pueblos poseen repertorios de conocimiento igualmente legítimos, desde la ciencia académica hasta la medicina tradicional o la jurisprudencia indígena, y que negar esa diversidad es una forma de injusticia. Por tanto, lograr justicia cognitiva implica redistribuir poder epistémico: cuestionar quién decide qué datos recopilar, cómo se interpretan y para qué fines se usan.

Un ejemplo revelador: el algoritmo del Sisbén IV

En 2021, Colombia puso en marcha el Sisbén IV[1]. El Sisbén combina una encuesta presencial que recoge datos sobre ingreso, condiciones de vivienda y acceso a servicios, con un modelo de puntaje que ordena a los hogares en grupos de menor a mayor vulnerabilidad. Ese puntaje determina la entrada a subsidios como salud, transferencias monetarias o becas educativas, de modo que el sistema se presenta como un mecanismo “técnico” para asignar recursos públicos con mayor precisión.

Sin embargo, una auditoría ciudadana liderada por colectivos afrodescendientes y organizaciones de derechos digitales reveló que el algoritmo de Sisbén IV penalizaba a familias de la región pacífica que carecían de recibos formales de servicios públicos, un requisito implícito en varias variables predictoras. La ausencia de esa documentación redujo su puntaje en promedio un 12 %, lo que limita su acceso a salud y educación (Smart, 2024).

Así, quedó demostrado que el sesgo no se encontraba solo en la programación, sino en la lógica de datos que invisibilizaba prácticas de economía informal (Smart, 2024). Al confrontar al Departamento Nacional de Planeación, los colectivos afrodescendientes y organizaciones de derechos digitales exigieron la apertura del código fuente, es decir, la publicación de las reglas de clasificación para permitir su auditoría externa y la reclasificación de variables desde una perspectiva intercultural (Colectivo EtniCidad, 2023). Tras varios meses de diálogo público, el Gobierno expidió la Resolución 1178 de 2023, que incorpora indicadores de pertenencia étnica y redes de cuidado comunitario en el Sisbén IV (DNP, 2023).

Este caso ilustra dos hallazgos clave. Primero, los algoritmos reproducen jerarquías cuando se alimentan con datos “colonizados”, es decir, basados en supuestos urbanos y formales que desatienden economías informales y modos de vida rurales. Y segundo, la movilización social puede reconfigurar la infraestructura de poder digital, y obliga a la aplicación de ajustes normativos y técnicos que amplían la justicia distributiva y epistémica (Benjamin, 2019).

La auditoría al Sisbén refleja un principio más amplio: sin soberanía de datos no hay justicia social en la era algorítmica. Dicha soberanía implica que las personas y colectivos tengan el derecho a gobernar todo el ciclo de vida de la información que les concierne, desde la recolección, almacenamiento, procesamiento y finalmente reutilización de sus datos, de acuerdo con sus valores, normas y prioridades (Kukutai y Taylor, 2016; Rainie et al., 2017). Este enfoque, originado en las luchas de los pueblos indígenas por controlar sus registros demográficos y territoriales, se ha ampliado para cuestionar que los datos de las comunidades queden cautivos en infraestructuras empresariales o estatales, que rara vez rinden cuentas a quienes generan esa información (Milan y Treré, 2019).

A esta reivindicación se suma la ciencia ciudadana, definida como la participación abierta del público en procesos científicos (Haklay, 2013). En la última década, han surgido plataformas donde las mismas comunidades entrenan modelos y curan bases de datos, lo que permite unificar el conocimiento local con técnicas de aprendizaje automático.

La relación entre soberanía de datos y ciencia ciudadana es sinérgica: la primera establece el marco ético-político, que garantiza que los datos permanezcan bajo control comunitario, mientras la segunda provee los métodos participativos que transforman esos datos en inteligencia colectiva. Esta sinergia promueve la participación ciudadana, en tanto convierte la IA en una herramienta de autodeterminación, capaz de redistribuir poder epistémico y disputar el monopolio de la predicción ambiental y social históricamente reservada a agencias estatales o corporativas.

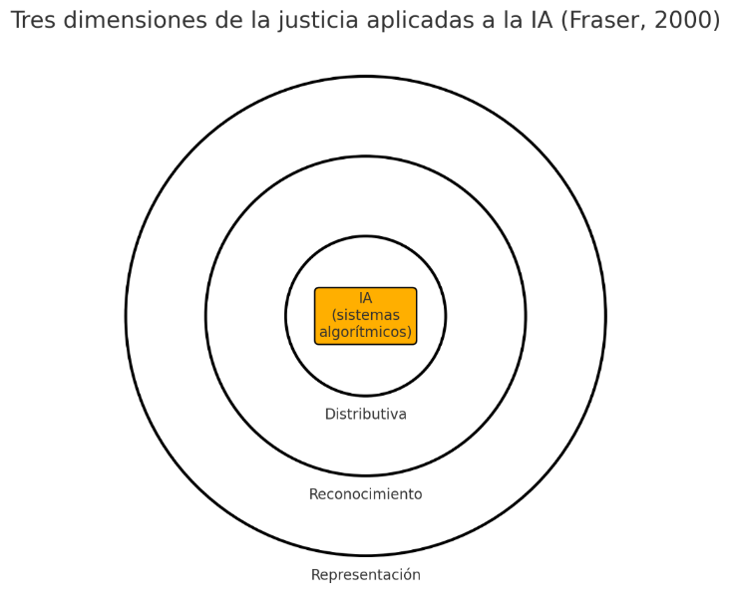

Esta premisa lleva a pensar en la manera de poner la IA al servicio de la justicia social, mediante la convergencia de la soberanía de datos y la ciencia ciudadana. Para esto, es posible visibilizar la justicia en tres dimensiones, como propone Fraser (2000): distributiva, de reconocimiento y de representación.

Figura 1. Representación de las tres dimensiones de la justicia social —distributiva, de reconocimiento y de representación— propuestas por Fraser (2000) y su intersección en los sistemas de IA. Fuente: elaboración propia.

El uso de la IA transversaliza las tres a la vez:

- Distributiva: ¿quién recibe beneficios o carga los costos de una decisión algorítmica?

- Reconocimiento: ¿qué identidades y saberes son validados en los datos?

- Representación: ¿quién participa en el diseño y la gobernanza del sistema?

Otro caso que permite evaluar la magnitud del impacto de la inteligencia artificial es el proyecto comunitario Alerta de Mareas Rojas, en Cartagena (Colombia), producto de la iniciativa comunitaria. Revela cómo la tecnología puede apalancar la justicia social cuando se articula con saberes territoriales y procesos participativos. Este proyecto comunitario creado en 2022 por pescadores artesanales de Cartagena junto con la Universidad de Cartagena e INVEMAR[2], integró sensores de bajo costo con redes neuronales para predecir floraciones algales (International Science Council, 2025). Gracias a estas alertas, las familias pesqueras evitan pérdidas de capturas, confirman sus saberes sobre el color y olor del agua, y participan en un comité que decide cada mejora que se implementa al sistema. Respecto a este caso de participación ciudadana a través de algoritmo, se pueden identificar las tres dimensiones de justicia:

- Distributiva: las alertas tempranas protegen la pesca artesanal, principal sustento de los hogares, al evitar cierres imprevistos que solo beneficiarían a las grandes navieras[3].

- Reconocimiento: el modelo incorpora indicadores cualitativos aportados por pescadores sobre cambios de color y olor del agua, para validad conocimiento local que no aparece en bases de datos oficiales.

- Representación: una mesa técnica comunitaria decide cómo y cuándo se recalibra el algoritmo, para garantizar que las comunidades costeras tengan voz y voto en la gobernanza de la plataforma.

Si se compara el ejemplo anterior con el caso del Sisbén, la dimensión distributiva se hizo evidente en la asignación de subsidios. El reconocimiento falló al invisibilizar las situaciones sociales y económicas de las comunidades afro, y la representación comenzó a repararse cuando el colectivo ingresó a la mesa técnica. Estos hechos evidencian que la justicia algorítmica va más allá de eliminar sesgos aislados: exige articular la equidad distributiva, el reconocimiento intercultural y la participación democrática en el ciclo de vida de los datos. Por ello, se propone un enfoque comunitario y participativo que combine soberanía de datos, ciencia ciudadana y marcos de gobernanza ética para que la IA contribuya a la transformación social en lugar de reproducir desigualdades (Benjamin, 2019; Crawford, 2021).

Principios para una IA decolonial y comunitaria

A la luz de estas reflexiones, se proponen cinco principios concebidos como puntos de conversación que deben articularse en el uso de la IA en procesos sociales: participación vinculante, apertura deliberativa, cuidado ecosocial, redistribución de valor y educación crítica.

En primer lugar, la participación vinculante exige que todo sistema capaz de afectar derechos incorpore mesas comunitarias con poder de voto efectivo, derecho de veto y evaluación periódica. De este modo las comunidades son escuchadas para que puedan incidir materialmente en las decisiones, como la definición de objetivos, métricas y salvaguardas.

En segundo lugar, es necesario promover una apertura deliberativa, que hace referencia a la transparencia en los procesos, como ir más allá de la mera publicación del código, pues también implica liberar los datos y las métricas de desempeño, lo que asegura una rendición de cuentas completa y diferenciada.

Asimismo, el cuidado ecosocial procura alinear la IA con la mitigación climática y la protección de la vida humana y no humana. El término combina dos perspectivas: la ecológica, preservar los sistemas biofísicos que sostienen la vida; y la perspectiva social, que se ocupa de las relaciones de poder y la distribución de riesgos y beneficios (Benach y Muñoz, 2021; Krieger, 2012) para integrar parámetros ambientales y éticos en todo el ciclo de vida tecnológico.

Este enfoque se complementa con la redistribución de valor, que implica que las plataformas que se lucran de datos comunitarios deben constituir fondos que devuelvan beneficios económicos o sociales a las propias comunidades que generan dicha información.

Finalmente, estos principios solo serán sostenibles si se incorpora una educación crítica que, desde la escuela primaria, no solo enseñe alfabetización digital básica, sino también epistemología de datos, de manera que cualquier persona pueda interpelar un algoritmo con la misma solvencia con la que cuestiona un libro de texto, lo que podría garantizar una ciudadanía plenamente informada y empoderada frente a los sistemas sociotécnicos que configuran su vida cotidiana.

Estos principios están diseñados para las instituciones que inciden en las comunidades donde la IA se implementa; por ello, el Estado y los demás organismos públicos no pueden delegar la ética en simples “códigos de conducta” voluntarios. Se requieren marcos regulatorios, evaluaciones de impacto algorítmico ex ante y ex post, registros públicos de modelos y sanciones proporcionales. Actualmente, Brasil discute el Proyecto de Ley n.º 2338 de 2023[4], que dota a la IA de un enfoque basado en derechos; la Unión Europea ha publicado el Artificial Intelligence Act en su Diario Oficial[5]; y Colombia, tras las controversias del Sisbén IV, abrió consultas sobre una Política Nacional de IA Ética que prevé un consejo ciudadano permanente[6].

Estas experiencias demuestran que la regulación efectiva combina obligaciones jurídicas con participación social. Por esto al tratar el tema de la IA a espacios de conversación se sabe que el entusiasmo tecnológico o el rechazo visceral a la tecnología no bastan para plantearnos su uso e impacto. La IA puede amplificar las posibilidades cuando las comunidades son autoras de sus propios datos, pero también puede convertirse en una problemática si se desvincula de la participación social. Vale la pena recordar la advertencia realizada por Eubanks (2018): automatizar la desigualdad es más fácil que erradicarla.

Conclusiones

La “revolución silenciosa” consiste en decidir, de manera consciente y colectiva, cómo se espera que la inteligencia artificial moldee las vidas de las personas, al pretender que pase desapercibida y tome decisiones por nosotros, o si habrá participación activa para un uso ético de las nuevas tecnologías. Dentro de la discusión se planteó el favorecimiento de la justicia social, y por ello se propusieron cinco principios enlazados entre sí que podrían aportar a la conversación: la participación vinculante, que otorga a las comunidades poder real de decisión sobre cualquier sistema que afecte sus derechos; la apertura deliberativa, que exige transparencia plena no solo del código, sino también de los datos y las métricas de desempeño; el cuidado ecosocial, que alinea los objetivos algorítmicos con la protección de la vida humana y no humana; la redistribución de valor, mediante la cual las plataformas que obtienen beneficios de los datos comunitarios devuelven parte de esos beneficios a quienes los generan; y, finalmente, la educación crítica, que forma a la ciudadanía para interpelar y moldear la tecnología desde temprana edad. Estos principios muestran que la IA no es inevitablemente justa ni injusta: su impacto depende de las reglas y de los pactos sociales que la acompañan.

Esta mirada convoca a pensar si la inteligencia artificial, lejos de ser una solución neutral, se despliega como un territorio donde se entrelazan disputas éticas, políticas y epistémicas. Al observar el caso del Sisbén IV, se advierte cómo los algoritmos pueden profundizar asimetrías históricas cuando se alimentan de datos sesgados, pero también cómo pueden reorientarse cuando las comunidades reclaman voz y soberanía sobre su información. Ese punto de partida nos lleva a dialogar con la ética decolonial, el cuidado ecosocial y los principios de participación democrática, con la esperanza de articularlos en un marco que acompañe los futuros desarrollos tecnológicos.

Si algo queda claro es que los algoritmos, por sí mismos, ni perpetúan ni corrigen injusticias: son las relaciones y ausencias de poder las que determinan su trayectoria. De ahí que el compromiso ético no pueda limitarse a lineamientos abstractos ni a apelaciones a la transparencia, sino que deba encarnarse en procesos de deliberación colectiva, marcos regulatorios y prácticas de ciencia ciudadana que devuelvan la agencia a quienes históricamente han sido objeto, y no sujeto, de la mirada estadística.

La invitación final es, por tanto, a mantener abierto este proceso: a cuestionar cada métrica, cada dato y cada decisión de diseño desde la pregunta por la justicia, la memoria y la pluralidad de saberes. Si la IA ha de servir para imaginar futuros más dignos, necesitará nutrirse de pactos sociales que la excedan, de políticas que la interroguen y de comunidades que la escuchen y la transformen.

Se extiende entonces una invitación a promover la discusión más allá de estas páginas. Que cada línea de código lleve impresa la huella de un pacto social donde la justicia no sea un subproducto, sino la razón de ser de la innovación. Porque, al final, la IA será tan justa como lo sea la comunidad que la sueña, la diseña y la modera.

Referencias bibliográficas

Benjamin, R. (2019). Race after technology: Abolitionist tools for the New Jim Code. Polity Press.

Buolamwini, J. y Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. Proceedings of Machine Learning Research, 81, 77-91. https://proceedings.mlr.press/v81/buolamwini18a/buolamwini18a.pdf

Castells, M. (2012). Redes de indignación y esperanza: Movimientos sociales en la era de Internet. Alianza Editorial.

Colectivo EtniCidad (2023, 22 de marzo). Carta abierta al DNP sobre sesgos étnicos en el Sisbén IV. https://colectivoetnicidad.org/sisben-iv

Departamento Nacional de Planeación (2023). Resolución 1178: Modificación de variables diferenciales en el Sisbén IV.

de Sousa Santos, B. (2014). Epistemologies of the South: Justice against epistemicide. Routledge.

Dignum, V. (2019). Responsible artificial intelligence: How to develop and use AI in a responsible way. Springer. https://doi.org/10.1007/978-3-030-30371-6

Eubanks, V. (2018). Automating inequality: How high‑tech tools profile, police, and punish the poor. St. Martin’s Press.

Floridi, L. (2023). The ethics of artificial intelligence. Oxford University Press. https://doi.org/10.1093/oso/9780198883098.001.0001

Fraser, N. (2000). Rethinking recognition. New Left Review, 3, 107–120.

Haklay, M. (2013). Citizen science and volunteered geographic information: Overview and typology. En D. Sui, S. Elwood y M. Goodchild (Eds.), Crowdsourcing geographic knowledge (pp. 105–122). Springer. https://doi.org/10.1007/978-94-007-4587-2_7

International Science Council (2025). Artificial intelligence in Latin America: Case study Colombia. International Science Council.

Kukutai, T. y Taylor, J. (Eds.) (2016). Indigenous data sovereignty: Toward an agenda. ANU Press. https://doi.org/10.22459/CAEPR38.11.2016

Milan, S. y Treré, E. (2019). Big data from the South(s): Beyond data universalism. Television & New Media, 20(4), 319–335. https://doi.org/10.1177/1527476419837739

Mignolo, W. D. (2011). The darker side of Western modernity: Global futures, decolonial options. Duke University Press.

Noble, S. U. (2018). Algorithms of oppression: How search engines reinforce racism. NYU Press. https://doi.org/10.2307/j.ctt1pwt9w5

Rainie, S. C., Schultz, J. L., Briggs, E., Riggs, P. y Palmanteer‑Holder, N. L. (2017). Data as strategic resource: Self‑determination and the data challenge for United States Indigenous nations. International Indigenous Policy Journal, 8(2), 1–29. https://doi.org/10.18584/iipj.2017.8.2.1

Ricaurte, P. (2019). Data epistemologies, the coloniality of power, and resistance. Television & New Media, 20(4), 350–365. https://doi.org/10.1177/1527476419831640

Smart, V. (2024). Algorithmic discrimination in Latin American welfare states. Carr Center Discussion Paper 24‑01. Harvard University. https://www.hks.harvard.edu/sites/default/files/2024-08/24_Smart_Final_01.pdf

Stake, R. E. (1995). The art of case study research. Sage Publications.

Notas al pie

[1] Sistema de Identificación y Clasificación de Potenciales Beneficiarios de Programas Sociales en Colombia, la cuarta actualización de un instrumento creado en 1994 y administrado por el Departamento Nacional de Planeación (DNP).

[2] Instituto de Investigaciones Marinas y Costeras, organización que administra los datos de investigación costera, vinculada al Ministerio de Ambiente de Colombia.

[3] Empresa que opera barcos para mover cargas o pasajeros por mar.

[4] Texto completo disponible en el portal del Senado Federal de Brasil: Projeto de Lei n.º 2338/2023 (Senado Federal, 2024).

[5] El Artificial Intelligence Act es el primer marco legal integral sobre IA del mundo, el cual es oficial y ha iniciado su calendario de aplicación obligatoria. Las organizaciones que desarrollen, comercialicen o utilicen IA en la UE —incluidas las construidas fuera de la UE que quieran operar en su mercado— deben empezar a evaluar sus sistemas bajo el enfoque de riesgo del AI Act y prepararse para demostrar cumplimiento dentro de los plazos señalados. Versión oficial del Regulation (EU) 2024/1689 —Artificial Intelligence Act— en el Diario Oficial de la Unión Europea (European Parliament & Council, 2024).

[6] Documento CONPES 4144: Política Nacional de Inteligencia Artificial accesible en la página del Departamento Nacional de Planeación de Colombia (DNP, 2025).

La invitación final es, por tanto, a mantener abierto este proceso: a cuestionar cada métrica, cada dato y cada decisión de diseño desde la pregunta por la justicia, la memoria y la pluralidad de saberes. Si la IA ha de servir para imaginar futuros más dignos, necesitará nutrirse de pactos sociales que la excedan, de políticas que la interroguen y de comunidades que la escuchen y la transformen.